Historia sztucznej inteligencji może wydawać się ciężką i nieprzystępną tematyką dla osób, które nie są dobrze zaznajomione z informatyką i jej poddziedzinami.

Pomimo tego, jak tajemnicza i niedostępna może wydawać się sztuczna inteligencja, kiedy jest ona rozbijana na mniejsze części, jest znacznie łatwiej ją zrozumieć, niż mogłoby się wydawać. Mówiąc prostym językiem, AI to zrozumienie, że maszyny mogą interpretować, przeszukiwać i uczyć się z zewnętrznych danych w taki sposób, że te maszyny naśladują funkcjonalnie procesy poznawcze, które zwykle przypisuje się ludziom. Sztuczna inteligencja opiera się na przekonaniu, że ludzkie procesy myślowe mają zdolność do replikacji i mechanizacji.

Historia sztucznej inteligencji sięga starożytności, kiedy to filozofowie zastanawiali się nad ideą, że istnieją lub mogą istnieć w pewnej formie sztuczne istoty, mechaniczni ludzie i inne automaty.

Dzięki wczesnym myślicielom, sztuczna inteligencja stała się coraz bardziej namacalna w XVIII wieku i później. Filozofowie zastanawiali się, jak ludzkie myślenie można by sztucznie zmechanizować i manipulować za pomocą inteligentnych, nie-ludzkich maszyn. Procesy myślowe, które zasiliły zainteresowanie AI, zaczęły się, gdy klasyczni filozofowie, matematycy i logicy zaczęli rozważać manipulację symbolami (mechanicznie), co ostatecznie doprowadziło do wynalezienia programowalnego komputera cyfrowego, Atanasoff Berry Computer (ABC) w latach 40. XX wieku. To konkretne wynalazek zainspirowało naukowców do pójścia dalej z ideą stworzenia „elektronicznego mózgu”, czyli sztucznie inteligentnej istoty.

Zanim minęło prawie dziesięciolecie, ikony w dziedzinie AI pomogły zrozumieć pole, które mamy dzisiaj. Alan Turing, matematyk między innymi, zaproponował test mierzący zdolność maszyny do naśladowania ludzkich działań do stopnia, który był nieodróżnialny od ludzkiego zachowania. Później w tym samym dziesięcioleciu, dziedzina badań nad AI została założona podczas letniej konferencji w Dartmouth College w połowie lat 50., gdzie John McCarthy, komputerowiec i kognitywista, ukutył termin „sztuczna inteligencja”.

Od lat 50. wielu naukowców, programistów, logików i teoretyków pomogło ugruntować nowoczesne zrozumienie sztucznej inteligencji jako całości. Każda nowa dekada przynosiła innowacje i odkrycia, które zmieniały podstawową wiedzę ludzi na temat dziedziny sztucznej inteligencji i tego, jak historyczne postępy przekształciły AI z nieosiągalnej fantazji w namacalną rzeczywistość dla obecnych i przyszłych pokoleń.

Kluczowe wydarzenia w historii sztucznej inteligencji

Nie jest zaskakujące, że sztuczna inteligencja rozwijała się dynamicznie po roku 1900, ale co jest zaskakujące, to fakt, ile osób myślało o AI setki lat przed tym, zanim nawet pojawiło się słowo, które opisywałoby to, o czym myśleli.

AI od 380 p.n.e. do 1900 r.

Między 380 r. p.n.e. a późnymi latami 1600: różni matematycy, teolodzy, filozofowie, profesorowie i autorzy zastanawiali się nad technikami mechanicznymi, maszynami liczącymi i systemami numerycznymi, które ostatecznie doprowadziły do koncepcji zmechanizowanego „ludzkiego” myślenia w istotach nie-ludzkich.

Wczesne lata 1700: W literaturze popularnej coraz częściej dyskutowano na temat wszechwiedzących maszyn przypominających komputery. W powieści Jonathana Swifta „Podróże Guliwera” wspomniano o urządzeniu zwanych silnikiem, które jest jednym z najwcześniejszych odniesień do technologii współczesnej, konkretnie do komputera. Zamierzeniem tego urządzenia było doskonalenie wiedzy i operacji mechanicznych do punktu, w którym nawet najmniej utalentowana osoba wydawałaby się być wykwalifikowana – wszystko za pomocą i wiedzy nie-ludzkiego umysłu (naśladującego sztuczną inteligencję.)

1872: W powieści Samuela Butlera „Erewhon” pojawia się zabawa myślą, że w nieokreślonym punkcie przyszłości maszyny będą miały potencjał do posiadania świadomości.

AI od 1900-1950

Kiedy nadszedł XX wiek, tempo, z jakim rozwijała się innowacja w sztucznej inteligencji, było znaczące.

1921: Karel Čapek, czeski dramaturg, wydał swoją sztukę science fiction „Rossum’s Universal Robots”. Sztuka ta badała koncepcję sztucznie wyprodukowanych ludzi, których nazywał robotami – jest to pierwsze znane odniesienie do tego słowa. Od tego momentu ludzie przejęli pomysł „robota” i włączyli go do swoich badań, sztuki i odkryć.

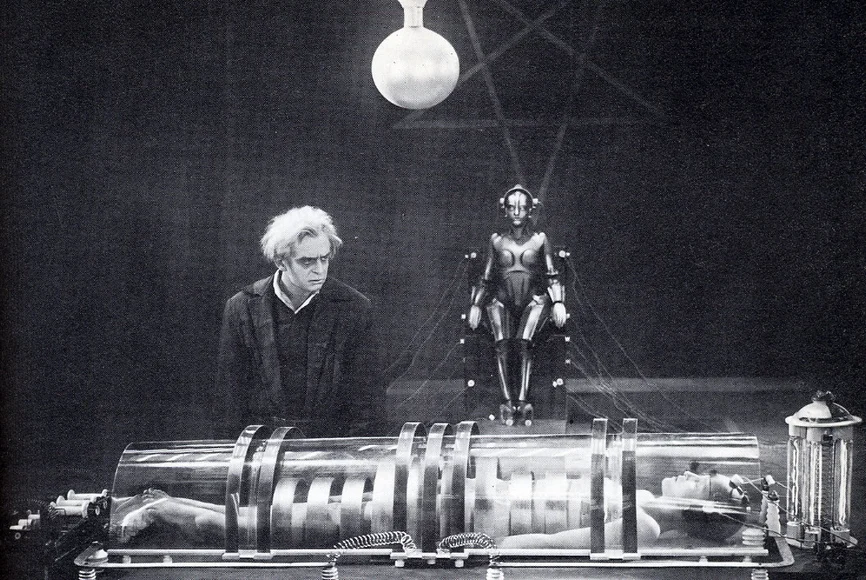

1927: Film science-fiction Metropolis, w reżyserii Fritza Langa, przedstawiał robotyczną dziewczynę, która fizycznie nie różniła się od swojego ludzkiego odpowiednika, od którego zaczerpnęła swój wygląd. Sztucznie inteligentna robotyczna dziewczyna następnie atakuje miasto, siając spustoszenie w futurystycznym Berlinie. Ten film ma znaczenie, ponieważ jest to pierwsze filmowe przedstawienie robota i zainspirowało tym samym inne słynne postacie nie-ludzkie, takie jak C-3PO w Gwiezdnych Wojnach.

1929: Japoński biolog i profesor Makoto Nishimura stworzył Gakutensoku, pierwszego robota zbudowanego w Japonii. Gakutensoku tłumaczy się jako „uczenie się od praw natury”, co sugeruje, że sztucznie inteligentny umysł robota mógł czerpać wiedzę od ludzi i z natury. Niektóre z jego funkcji obejmowały poruszanie głową i rękami oraz zmianę wyrazów twarzy.

1939: John Vincent Atanasoff (fizyk i wynalazca) wraz ze swoim asystentem, studentem podyplomowym Cliffordem Berrym, stworzyli Komputer Atanasoffa-Berry’ego (ABC) dzięki grantowi w wysokości 650 dolarów na Iowa State University. ABC ważył ponad 700 funtów i mógł rozwiązać do 29 równań liniowych jednocześnie.

1949: Książka informatyka Edmunda Berkeleya „Giant Brains: Or Machines That Think” zauważała, że maszyny są coraz bardziej zdolne do przetwarzania dużych ilości informacji z prędkością i umiejętnościami. Porównał potem maszyny do ludzkiego mózgu, gdyby był on zrobiony z „hardware’u i przewodów zamiast mięśni i nerwów”, opisując zdolności maszyny do myślenia na równi z ludzkim umysłem, stwierdzając, że „maszyna, więc może myśleć”.

AI w latach 50.

Lata 50. okazały się czasem, kiedy wiele postępów w dziedzinie sztucznej inteligencji zaczęło przynosić owoce, a badania nad AI prowadzone przez różnych informatyków i innych naukowców zyskiwały na sile.

1950: Claude Shannon, „ojciec teorii informacji”, opublikował „Programming a Computer for Playing Chess”, co było pierwszym artykułem omawiającym rozwój programu komputerowego do gry w szachy.

1950: Alan Turing opublikował „Computing Machinery and Intelligence”, który zaproponował pomysł Imitation Game – pytanie, które rozważało, czy maszyny mogą myśleć. Ta propozycja później stała się Testem Turinga, który mierzył inteligencję maszynową (sztuczną). Rozwój Turinga testował zdolność maszyny do myślenia jak człowiek. Test Turinga stał się ważnym elementem filozofii sztucznej inteligencji, która omawia inteligencję, świadomość i zdolności maszyn.

1952: Arthur Samuel, informatyk, opracował program komputerowy do gry w warcaby – pierwszy, który nauczył się samodzielnie grać w grę.

1955: John McCarthy i zespół mężczyzn stworzyli propozycję warsztatu na temat „sztucznej inteligencji”. W 1956 roku, kiedy warsztat się odbył, oficjalne narodziny tego słowa przypisano McCarthy’emu.

1955: Allen Newell (badacz), Herbert Simon (ekonomista) i Cliff Shaw (programista) współautorzy Logic Theorist, pierwszego programu komputerowego do sztucznej inteligencji.

1958: McCarthy opracował Lisp, najpopularniejszy i nadal preferowany język programowania do badań nad sztuczną inteligencją.

1959: Samuel ukutał termin „uczenie maszynowe”, mówiąc o programowaniu komputera do gry w szachy lepiej niż człowiek, który napisał jego program.

AI w latach 60.

Innowacje w dziedzinie sztucznej inteligencji gwałtownie rosły w latach 60. Tworzenie nowych języków programowania, robotów i automatów, studiów badawczych oraz filmów przedstawiających istoty o sztucznej inteligencji zyskiwało na popularności. Wyraźnie podkreślało to znaczenie AI w drugiej połowie XX wieku.

1961: Unimate, przemysłowy robot wynaleziony przez George’a Devola w latach 50., stał się pierwszym, który pracował na linii montażowej General Motors w New Jersey. Do jego obowiązków należało transportowanie odlewów z linii montażowej i spawanie części do samochodów – zadanie uznane za niebezpieczne dla ludzi.

1961: James Slagle, informatyk i profesor, opracował SAINT (Symbolic Automatic INTegrator), heurystyczny program rozwiązujący problemy, którego głównym celem była symboliczna integracja na pierwszym roku studiów z zakresu rachunku różniczkowego i całkowego.

1964: Daniel Bobrow, informatyk, stworzył STUDENT, wczesny program AI napisany w Lispie, który rozwiązywał słowne problemy algebraiczne. STUDENT jest cytowany jako jeden z wczesnych kamieni milowych przetwarzania języka naturalnego w AI.

1965: Joseph Weizenbaum, informatyk i profesor, opracował ELIZĘ, interaktywny program komputerowy, który mógł funkcjonalnie rozmawiać po angielsku z osobą. Celem Weizenbauma było pokazanie, jak komunikacja pomiędzy sztucznie inteligentnym umysłem a ludzkim umysłem jest „powierzchowna”, ale odkrył, że wiele osób przypisywało ELIZIE cechy antropomorficzne.

1966: Shakey the Robot, opracowany przez Charlesa Rosena przy pomocy 11 innych osób, był pierwszym uniwersalnym robotem mobilnym, znanym również jako „pierwsza elektroniczna osoba”.

1968: Wydano film science fiction 2001: Odyseja kosmiczna, w reżyserii Stanleya Kubricka. Zawiera on postać HAL (Heurystycznie zaprogramowany komputer ALgorytmiczny), świadomy komputer. HAL kontroluje systemy statku kosmicznego i oddziałuje na załogę statku, rozmawiając z nimi tak, jakby HAL był człowiekiem, dopóki awaria nie zmienia interakcji HAL na niekorzyść.

1968: Terry Winograd, profesor informatyki, stworzył SHRDLU, jeden z pierwszych programów komputerowych obsługujących język naturalny.

AI w latach 70.

Podobnie jak lata 60., lata 70. przyniosły przyspieszone postępy, szczególnie skoncentrowane na robotach i automatach. Jednak sztuczna inteligencja w latach 70. napotkała na wyzwania, takie jak zmniejszone wsparcie rządowe dla badań nad AI.

1970: WABOT-1, pierwszy robot antropomorficzny, został zbudowany w Japonii na Uniwersytecie Waseda. Jego funkcje obejmowały ruchome kończyny, zdolność do widzenia i rozmawiania.

1973: James Lighthill, matematyk stosowany, przedstawił stan badań nad sztuczną inteligencją Brytyjskiej Radzie Naukowej, stwierdzając: „w żadnej części tego pola dotychczasowe odkrycia nie wywarły tak dużego wpływu, jakiego wówczas obiecywano”, co doprowadziło do znacznego ograniczenia wsparcia dla badań nad sztuczną inteligencją przez rząd brytyjski.

1977: Reżyser George Lucas wydaje film Gwiezdne Wojny. Film przedstawia C-3PO, humanoidnego robota zaprojektowanego jako droid protokolarny, który „mówi biegle w ponad siedmiu milionach form komunikacji”. Jako towarzysz C-3PO, film przedstawia również R2-D2 – małego droida astromechanicznego, który nie jest zdolny do mowy ludzkiej (odwrotność C-3PO); zamiast tego R2-D2 komunikuje się elektronicznymi dźwiękami. Jego funkcje obejmują drobne naprawy i współpilotowanie statków kosmicznych.

1979: Stanford Cart, zdalnie sterowany robot mobilny wyposażony w telewizor, został stworzony przez ówczesnego studenta inżynierii mechanicznej Jamesa L. Adamsa w 1961 roku. W 1979 roku „slider”, czyli mechanizm obrotowy, który przesuwał kamerę telewizyjną z boku na bok, został dodany przez Hansa Moravca, ówczesnego studenta doktoranckiego. Wózek z powodzeniem przeciął pokój wypełniony krzesłami bez ingerencji człowieka w ciągu około pięciu godzin, co czyni go jednym z najwcześniejszych przykładów pojazdu autonomicznego.

AI w latach 80.

Szybki rozwój sztucznej inteligencji trwał przez lata 80. Pomimo postępów i entuzjazmu wokół AI, ostrożność otaczała nieuchronną „Zimę AI”, okres zmniejszonego finansowania i zainteresowania sztuczną inteligencją.

1980: WABOT-2 został zbudowany na Uniwersytecie Waseda. Pozwoliło to humanoidowi komunikować się z ludźmi, a także czytać partytury muzyczne i grać muzykę na elektronicznych organach.

1981: Japońskie Ministerstwo Handlu Międzynarodowego i Przemysłu przeznaczyło 850 milionów dolarów na projekt Komputerów Piątej Generacji, którego celem było opracowanie komputerów, które mogłyby prowadzić rozmowy, tłumaczyć języki, interpretować obrazy i wyrażać rozumowanie przypominające ludzkie.

1984: Film „Electric Dreams”, wyreżyserowany przez Steve’a Barrona, trafia do kin. Fabuła kręci się wokół trójkąta miłosnego między mężczyzną, kobietą i myślącym komputerem osobistym o nazwie „Edgar”.

1984: Na konferencji Association for the Advancement of Artificial Intelligence (AAAI), Roger Schank (teoretyk AI) i Marvin Minsky (naukowiec zajmujący się kognitywistyka) ostrzegali przed Zimą AI, pierwszym przypadkiem, gdy zainteresowanie i finansowanie badań nad sztuczną inteligencją spadłyby. Ich ostrzeżenie spełniło się w ciągu trzech lat.

1986: Mercedes-Benz zbudował i wypuścił na rynek samochód dostawczy bez kierowcy wyposażony w kamery i czujniki pod kierunkiem Ernsta Dickmannsa. Pojazd mógł jeździć z prędkością do 55 mil na godzinę na drodze bez innych przeszkód ani kierowców.

1988: Informatyk i filozof Judea Pearl opublikował „Probabilistic Reasoning in Intelligent Systems”. Pearl jest także uznawany za wynalazcę sieci bayesowskich, „probabilistycznego modelu graficznego”, który reprezentuje zbiory zmiennych i ich zależności za pomocą skierowanego grafu acyklicznego (DAG).

1988: Rollo Carpenter, programista i wynalazca dwóch chatbotów, Jabberwacky i Cleverbot (wydany w latach 90.), opracował Jabberwacky, aby „symulować naturalną rozmowę ludzką w interesujący, zabawny i humorystyczny sposób”. Jest to przykład komunikacji AI z ludźmi za pomocą chatbota.

AI w latach 90.

Koniec tysiąclecia był na horyzoncie, ale to oczekiwanie tylko pomogło sztucznej inteligencji w jej ciągłym rozwoju.

1995: Informatyk Richard Wallace opracował chatbota A.L.I.C.E (Artificial Linguistic Internet Computer Entity), inspirowanego ELIZĄ Weizenbauma. Tym, co odróżniało A.L.I.C.E. od ELIZY, było dodanie zbierania próbek danych w języku naturalnym.

1997: Informatycy Sepp Hochreiter i Jürgen Schmidhuber opracowali Long Short-Term Memory (LSTM), typ architektury rekurencyjnych sieci neuronowych (RNN) używany do rozpoznawania pisma ręcznego i mowy.

1997: Deep Blue, komputer grający w szachy opracowany przez IBM, stał się pierwszym systemem, który wygrał partię i mecz szachowy z aktualnym mistrzem świata.

1998: Dave Hampton i Caleb Chung wynaleźli Furby, pierwszego „zwierzęcego” robota zabawkę dla dzieci.

1999: W nawiązaniu do Furby, Sony wprowadziło AIBO (Artificial Intelligence RoBOt), robota psa domowego za 2000 dolarów, stworzonego, aby „uczyć się” poprzez interakcję ze swoim otoczeniem, właścicielami i innymi AIBO. Jego funkcje obejmowały zdolność rozumienia i reagowania na ponad 100 komend głosowych oraz komunikowanie się z właścicielem.

2000 – 2010

Nowe tysiąclecie było w toku – a po obawach związanych z problemem Y2K – AI nadal zyskiwała na popularności. Zgodnie z oczekiwaniami, powstało więcej istot wyposażonych w sztuczną inteligencję, a także twórcze media (konkretnie filmy) na temat koncepcji sztucznej inteligencji i kierunku, w którym może się ona kierować.

2000: Problem Y2K, znany również jako problem roku 2000, to klasa błędów komputerowych związanych z formatowaniem i przechowywaniem elektronicznych danych kalendarzowych począwszy od 01/01/2000. Ponieważ wszystkie oprogramowania internetowe i programy zostały stworzone w latach 1900., niektóre systemy miałyby problemy z adaptacją do nowego formatu roku 2000 (i późniejszych). Wcześniej te zautomatyzowane systemy musiały zmieniać tylko dwie ostatnie cyfry roku; teraz trzeba było zmieniać wszystkie cztery cyfry – wyzwanie dla technologii i jej użytkowników.

2000: Profesor Cynthia Breazeal opracowała Kismet, robota, który mógł rozpoznawać i symulować emocje za pomocą swojej twarzy. Był zbudowany jak ludzka twarz z oczami, ustami, powiekami i brwiami.

2000: Honda wprowadza ASIMO, sztucznie inteligentnego robota humanoida.

2001: Wydany zostaje film science-fiction „A.I. Sztuczna Inteligencja” w reżyserii Stevena Spielberga. Film rozgrywa się w futurystycznym, dystopijnym społeczeństwie i śledzi losy Davida, zaawansowanego humanoida w postaci dziecka, którego zaprogramowano z antropomorficznymi uczuciami, w tym zdolnością do kochania.

2002: i-Robot wprowadził na rynek Roomba, autonomicznego robota odkurzającego, który sprząta, unikając przeszkód.

2004: Roboticzne łaziki badawcze NASA, Spirit i Opportunity, przemierzają powierzchnię Marsa bez ingerencji człowieka.

2004: Wydany zostaje film science-fiction „Ja, Robot” w reżyserii Alexa Proyasa. Akcja filmu rozgrywa się w 2035 roku, gdy roboty humanoidalne służą ludzkości, a jeden z indywidualistów jest zdecydowanie przeciwny robotom, ze względu na wynik osobistej tragedii (ustalonej przez robota).

2006: Oren Etzioni (profesor informatyki), Michele Banko i Michael Cafarella (informatycy) ukuli termin „czytanie maszynowe”, definiując je jako nienadzorowane autonomiczne rozumienie tekstu.

2007: Profesor informatyki Fei Fei Li i koledzy zebrała ImageNet, bazę danych obrazów z adnotacjami, której celem jest wspomaganie badań nad oprogramowaniem do rozpoznawania obiektów.

2009: Google potajemnie opracowało samochód bez kierowcy. Do 2014 roku przeszło testy na samodzielne prowadzenie w Nevadzie.

Do dzisiaj

Obecna dekada była niezwykle ważna dla innowacji w dziedzinie AI. Od 2010 roku sztuczna inteligencja stała się częścią naszego codziennego życia. Używamy smartfonów z asystentami głosowymi i komputerów z funkcjami „inteligencji”, które większość z nas uznaje za oczywiste. AI już od jakiegoś czasu nie jest marzeniem.

2010: ImageNet uruchomiło ImageNet Large Scale Visual Recognition Challenge (ILSVRC), ich coroczny konkurs AI na rozpoznawanie obiektów.

2010: Microsoft wprowadził na rynek Kinect dla Xbox 360, pierwsze urządzenie do gier, które śledziło ruchy ludzkiego ciała za pomocą kamery 3D i detekcji podczerwieni.

2011: Watson, komputer do odpowiadania na pytania w języku naturalnym stworzony przez IBM, pokonał dwóch byłych mistrzów Jeopardy!, Kena Jenningsa i Brada Ruttera, w telewizyjnej grze.

2011: Apple wydało Siri, wirtualnego asystenta w systemach operacyjnych Apple iOS. Siri korzysta z interfejsu użytkownika w języku naturalnym, aby wnioskować, obserwować, odpowiadać i rekomendować rzeczy swojemu ludzkiemu użytkownikowi. Dostosowuje się do poleceń głosowych i projektuje „indywidualne doświadczenie” dla każdego użytkownika.

2012: Jeff Dean i Andrew Ng (badacze z Google) przeszkolili dużą sieć neuronową z 16 000 procesorów do rozpoznawania obrazów kotów (mimo braku informacji wstępnych), pokazując jej 10 milionów nieoznaczonych obrazów z filmów na YouTube.

2013: Zespół badawczy z Uniwersytetu Carnegie Mellon opublikował Never Ending Image Learner (NEIL), semantyczny system uczenia maszynowego, który mógł porównywać i analizować relacje między obrazami.

2014: Microsoft wprowadził Cortanę, swoją wersję wirtualnego asystenta podobnego do Siri w systemie iOS.

2014: Amazon stworzył Amazon Alexa, asystenta domowego, który rozwinął się w inteligentne głośniki pełniące funkcję osobistych asystentów.

2015: Elon Musk, Stephen Hawking i Steve Wozniak wraz z 3 000 innych osób podpisali otwarty list zakazujący rozwijania i używania autonomicznych broni (do celów wojennych).

2015-2017: AlphaGo od Google DeepMind, program komputerowy grający w grę planszową Go, pokonał różnych (ludzkich) mistrzów.

2016: Robot humanoidalny o nazwie Sophia zostaje stworzony przez Hanson Robotics. Jest znana jako pierwszy „robot-obywatel”. To, co wyróżnia Sophię spośród wcześniejszych humanoidów, to jej podobieństwo do rzeczywistego człowieka, z jej zdolnością do widzenia (rozpoznawania obrazów), wyrażania emocji na twarzy i komunikowania się za pomocą AI.

2017: Laboratorium badań nad sztuczną inteligencją Facebooka przeszkoliło dwóch „agentów dialogowych” (chatbotów) do komunikowania się ze sobą, aby nauczyć się negocjować. Jednak, gdy chatboty rozmawiały, odbiegały od ludzkiego języka (zaprogramowanego w języku angielskim) i wynalazły własny język do komunikowania się ze sobą – wykazując sztuczną inteligencję w dużym stopniu.

2018: Alibaba (chińska grupa technologiczna) z językowym przetwarzaniem AI przewyższyła ludzki intelekt w teście czytania i zrozumienia Stanforda. Przetwarzanie językowe Alibaba uzyskało wynik „82,44 wobec 82,30 na zestawie 100 000 pytań” – to wąskie zwycięstwo, ale jednak porażka.

2018: Google opracowało BERT, pierwsze „dwukierunkowe, nienadzorowane reprezentowanie języka, które można wykorzystać do różnych zadań związanych z przetwarzaniem języka naturalnego, korzystając z uczenia transferowego.”

2018: Samsung wprowadził Bixby, wirtualnego asystenta. Funkcje Bixby obejmują Voice, gdzie użytkownik może mówić i zadawać pytania, rekomendacje i sugestie; Vision, gdzie zdolność Bixby do „widzenia” jest wbudowana w aplikację aparatu i może widzieć to, co widzi użytkownik (np. identyfikacja obiektów, wyszukiwanie, zakup, tłumaczenie, rozpoznawanie zabytków); i Home, gdzie Bixby wykorzystuje informacje oparte na aplikacjach, aby pomóc w interakcji z użytkownikiem (np. aplikacje pogodowe i fitnessowe).

A teraz? Tekst tłumaczy nam ChatGPT

Źródło: https://www.g2.com/articles/history-of-artificial-intelligence